IEEE Conference on Massive Data Storage (MSST 2012) 4 月 16-20 日。实验室曾老师中一篇short paper。

Flash 1

- Integrating Flash-based SSDs into the Storage Stack

- 文章使用一个基于插件的扩展工具插入到Loris 的框架中,在此基础上使用不同workloads 和不同混合存储构建进行比较,并提出了混合系统构建应该在应用和硬件上做权衡。

- Active Flash: Out-of-core Data Analytics on Flash Storage

- 提出了一种主动式Flash 的体系结构。探究了将计算从主机迁移到主动式Flash 上性能和能量的trade-offs,通过典型的嵌入式控制器的分析和任务的减少证明了可行性。并模拟学习了各种主动式Flash 调度策略。

- Flashy Prefetching for High-Performance Flash Drives

- 提出了一种Flash 预取策略,65-70%精度,平均20% 速度提升,对应的workloads 有LFS,web 搜索引擎,BLAST,TPC-H 等等。副作用包括可能会多读70%-90%的数据。所做工作和FAST11 中文章“FAST:Quick Application Launch on Solid-State Drives”很类似。 【值得一读】

- Mercury: Host-side Flash Caching for the Data Center 使用SSD 做DAS 缓存。

Parallel Object and Failure

- On the Role of Burst Buffers in Leadership-Class Storage Systems

- 高性能计算(HPC)存储系统中缓冲的重要作用,首先学习了当前大规模HPC 系统的应用I/O patterns,然后用CODES 存储模拟缓存。最终说明在这些workloads 下burst buffers 能够促进应用程序吞吐量。

- vPFS: Bandwidth Virtualization of Parallel Storage Systems

- 并行存储系统上的虚拟层,区分不同类型应用请求I/O,以满足QoS。原型PVFS2 实现。

- On the Speedup of Single-Disk Failure Recovery in XOR-Coded Storage Systems: Theory and Practice

- 中科大的一篇文章。加速基于XOR 纠错码的单盘错误恢复。理论方面:提出使用下山法的 replace recovery algorithm 寻找一个快速的恢复方案,为STAR 和CRS 提供了近乎最优的恢复性能。实践方面:在基于网络存储系统中测试了这个方法减少了恢复时间。【值得一读】

- An Active Storage Framework for Object Storage Devices 不说了,33 个引用三个老板的!

Short Papers 1

- A New High-performance, Energy-efficient Replication Storage System with Reliability Guarantee

- 谢老板那边出的。一种改良的软RAID:PRERAID,通过合并小写提高写性能、节省能量。(实验室毛博之前有篇Green RAID: GRAID)

- HRAID6ML: A Hybrid RAID6 Storage Architecture with Mirrored Loging

- 曾老师日志结构的RAID6。两块磁盘做奇偶校验盘,发挥其顺序读、写速度快的性能。其余都用SSD 提高读性能。

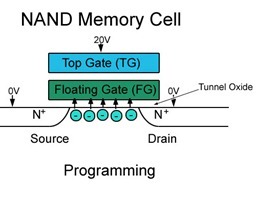

- Write Amplification due to ECC on Flash Memory or Leave those Bit Errors Alone

- 文章分析了Flash SSD 因为ECC 校验和擦除等操作会造成额外的写,从而造成写放大,减少了SSD 寿命。实验中通过积累一个page 的ECC 错误到一定阈值再处理减少了写放大,提高SSD 寿命40%。

- Storage Challenges at Los Alamos National Lab

- 洛斯-阿拉莫斯国家实验室(造出第一个原子弹)的存储挑战。见鬼!他们需要一个自己的并行文件系统。

- Adaptive Pipeline for Deduplication

- 南开大学的自适应流水线的重复数据删除。审稿不严啊!conclusion 中第一个deduplication 都拼写错了。

- Shortcut-JFS: A Write Efficient Journaling File System for Phase Change Memory

- 基于相变存储器(PCM)的日志文件系统 shortcut-JFS,论文提到了利用PCM 可以写到更小的单位,从而日志仅记录数据的变化—差量日志记录可能有点意思。实验用内存当的PCM 存储器。

Deduplication

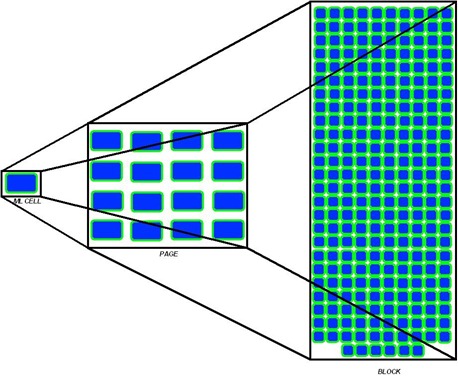

- Deduplication in SSDs: Model and Quantitative Analysis

- 在SSD 中使用重复数据删除可以提高写性能,垃圾回收和延长寿命。从建模到数值分析,文章为SSD 量身订做了一个重复数据删除的框架。Conclusion 最后提到的三点future works 可以参考。

- Design of an Exact Data Deduplication Cluster

- 大体意思是chunk index 分片保存在不同节点,使用更小的chunk size 进行重复数据删除。

- Estimation of Deduplication Ratios in Large Data Sets

- 提出一种估计重删率的技术,取样然后扫描。1MB 内存对7TB数据集估算只有1%误差。

Short Papers 2

- Jitter-Free Co-Processing on a Prototype Exascale Storage Stack

- 真心不知道说了什么,难道是为并行文件提供设计、实现了一种存储方案?

- Enhancing Shared RAID Performance Through online Profiling

- 还是谢老板那边的。多个服务器共享一个磁盘阵列性能较低,文章提出方法进行了改进。

- Exploiting superpages in a nonvolatile memory file system

- SLO-aware Hybrid Store

- A QoS Aware Non-work-conserving Disk Scheduler

- 预测请求的IO 调度器。

- Valmar: High-Bandwidth Real-Time Streaming Data Management

Flash 2

- ADAPT: Efficient Workload-Sensitive Flash Management Based on Adaptation, Prediction and Aggregation

- 一个混合映射(hybrid mapping)方案,包括自适应日志空间分区、预测性迁移、集成数据移动。key idea:If performance suffers from insufficient random log blocks, use blocks from sequential area, and vice versa.

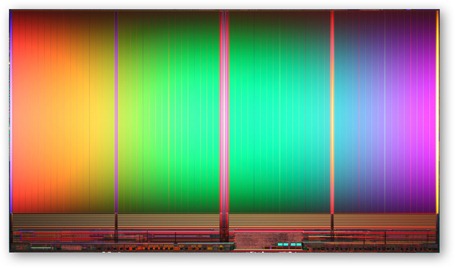

- NANDFlashSim: Intrinsic Latency Variation Aware NAND Flash Memory System Modeling and Simulation at Microarchitecture Level

- SSD 的一个模拟器,和胡杨博士的SSDSim 类似,也引用他在ICS 的文章,可参考这里。

- BloomStore: Bloom-Filter based Memory-Efficient Key-Value Store for Indexing of Data Deduplication on Flash

- 重删环境中的key-value store 需要高的吞吐量,文章使用SSD 和Bloom filter 提高吞吐量,提高get/lookup 操作效率。

快读paper 的几个技巧(欢迎补充)

- 首先看摘要,知道文章大体背景和概述。

- 如果Introduction 最后两段如果不是“section 2 将会讲……,section 3 讲……”,那么将会提到文章最核心,最创新的部分。有时候会直接给出“Our contributions/works are:……”

- 看conclusion ,看看作者通过自己的idea 和实验得出了什么结论。

- 看图表,简单直接知道实验内容。(有时图表和实验内容联系紧密,看图表看不出什么)。

- 最后还有时间穿插地瞄瞄Related works 和Our works(如果有的话)。说不定相关工作有你熟悉的内容。

- 另外能先看论文的PPT 也是非常好的方法。